亚马逊AWS针对人工智能推出新硬件

在今年的re:Invent年会上,AWS的首席执行官Andy Jassy和人工智能副总裁Swami Sivasubramanian发布了重要新闻。AWS针对人工智能推出了两款新的硬件,并且大幅度扩展了其SageMaker软件,以简化AWS上人工智能模型的运行,帮助它们获得最佳性能。当看到人工智能软件的广度、人工智能硬件的深度以及在AWS上使用人工智能客户的广度时,我们相信AWS在云人工智能服务方面已经超越了谷歌和微软。AWS最初只有一个简单的聊天机器人,具备文本、图片和语音识别功能,可是现在已经成了全球最全面的人工智能云服务领导者。

亚马逊还在继续打造其人工智能软件产品,在过去三年里,每年平均要增加200多项新功能。Amazon SageMaker Studio让人工智能的使用变成只需要点击这么简单,从而减少了对深度人工智能专业知识的需求。

如图2所示,Swami背后的幻灯片上显示了客户参与的范围,这些内容令人印象极为深刻。

来自英伟达、英特尔和AWS自身的新硬件

亚马逊基于开放性和客户选择,构建了行业最全面的基础架构服务。AWS EC2实例可提供其客户需要的各种样式的处理器和加速器,包括使用英特尔、AMD、Arm CPU、Xilinx FPGA、英伟达GPU以及AWS自己的人工智能加速器的实例。在本文中,我们将重点讨论最后一种情况。

去年,AWS推出了自主研发的Inferentia推理处理器,该处理器似乎吸引了亚马逊内部应用程序以外的关注。据AWS称,Inferentia提供了出色的性价比和延迟——据称吞吐量比GPU高出了35%,而价格却比GPU低了40%。值得注意的是,AWS没有说明他们是用哪些GPU与Inferentia进行对比的。

为了响应对英伟达A100 GPU的需求,AWS还推出了带有8个A100 GPU的P4d实例,这些实例可在4000 GPU GPU超级集群中使用。该产品旨在提供集成化且灵活的基础架构,以解决最大的培训任务。通过使用英伟达的HGX设计,P4d证明了英伟达在过去三年中通过不断地提升价值持续地改进了系统设计业务。它还显示出AWS愿意提供英伟达GPU的意愿——即使该公司也向其客户提供了替代产品。

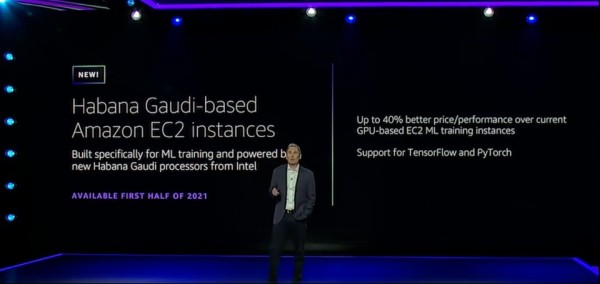

尽管AWS的客户对英伟达的GPU感到满意,但亚马逊一直在努力寻找更多具有成本效益并且性能更高的替代产品。在re:Invent年会上,AWS的首席执行官Andy Jassy宣布即将推出两个新的培训平台,这两个平台都将于明年推出。第一个平台使用了期待已久的英特尔Habana加速器, Jassy先生表示,这个平台的性价比将提高40%。在与英特尔的沟通中,我听说这一说法源自于一揽子基准测试,约占AWS上运行的人工智能工作的80%。

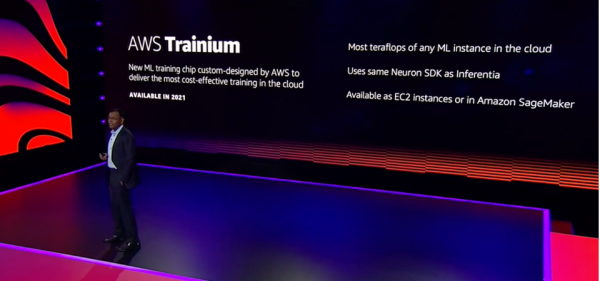

Jassy先生还宣布,AWS正在开发Inferentia的“大哥”,这款产品名为Trainium,它将“拥有云端所有机器学习实例中最多的万亿次浮点运算”。预计到了该服务在2021年晚些时候(也有可能是今年下半年)推出的时候,才会有更多的细节透露出来。和谷歌一样,AWS打算使用自己的人工智能芯片,用这种方式让自己针对人工智能的云服务与众不同,当然,这些芯片也只会被用于他们自己的云服务中。所以,短期内就不要指望能够购买到这些芯片用于本地运算了。

人工智能软件更新

AWS还宣布扩展SageMaker支持的数据和模型以进行分布式培训。当增加GPU容量时,这些改进将提供近乎线性的性能提升,自动将工作分散到整个集群之中。

该公告标志着AWS一直致力于增强Amazon SageMaker软件服务,专注于简化开发和部署。该公司现在拥有成千上万的客户在使用SageMaker,并将人工智能模型的开发时间从数周减少到数小时。

通常,为了方便开发,用户必须牺牲性能。数据科学家为了将吞吐量最大化并实现并行,通常会用手工编码的方式处理加速器指令集。但是,在这方面,亚马逊似乎通过SageMaker做得非常出色。

总结

AWS为人工智能提供了出色的GPU基础架构服务,但是,该公司的Lex和Text等人工智能工具似乎有些局限。快速前进了三年之后,一切都发生了变化,AWS通过Intel Habana增加了更多选择——这是第一家这样做的公司,但很有可能不会是最后一个。通过Tranium,AWS将很快与Google TPU和GPU展开直接竞争。同时,SageMaker开发团队一直非常繁忙,在努力地大幅扩展并增强其易于扩展的人工智能应用程序开发和部署。

凭借着这些稳定的发展和最近的公告,亚马逊AWS已经在人工智能方面占据了领导地位。

本文章选自《AI启示录》杂志,阅读更多杂志内容,请扫描下方二维码