入局AIGC 这家公司提供全方位的工具

当前,人们对AIGC的探索已经进入了商业化、规模化的阶段。随着越来越多的科技巨头加入这个赛道,创造出令人惊叹的AI生成作品,有理由相信,AIGC的大航海时代已经来临。

继AlhpaGo在围棋比赛中战胜人类之后,业界又在AIGC(AI Generated Content,AI生成内容)领域取得了一系列新突破。AI绘画《太空歌剧院》击败人类作品,拿到数字艺术比赛冠军,聊天对话机器人ChatGPT的综合文本创作能力已明显超过普通人。

AIGC逐渐受到大家的关注,目前已经可以自动生成文字、图片、音频、视频,甚至3D模型和代码。作为GPU加速计算的引领者,英伟达在驱动AIGC应用方面也发挥着重要作用。

NVIDIA高级解決方案架构师唐康祺告诉记者,英伟达在重构整个行业和社会的核心技术平台上,提供了全面的软硬件产品,为AIGC提供多方面的助力。

Omniverse平台——AI驱动内容生产

长期关注NVIDIA的朋友,一定对于黄教主的虚拟分身不陌生,虽然演讲中只有十几秒,但是已经非常震撼。

数字虚拟人是AIGC的重要方面,而针对设计协作、数字孪生、数字人的计算平台,Omniverse融合多领域技术,实现跨行业的3D设计设计协作和工业数字孪生。

唐康祺表示,NVIDIA打造Omniverse以实现虚拟世界,聚合3D工作流程提升设计师、艺术家和工程师创意效率。

例如针对虚拟数字人,Omniverse针对数字人有一系列不同的渲染机制,利用GPU渲染可以让数字人更接近真实的人类。

其次是RTX Render技术,即实时光线追踪技术。数字虚拟人会和周遭环境进行互动,模拟城市、人员、建筑等一系列复杂的生态环境系统都可以通过Omniverse完成。

Stable Diffusion是2022年发布的深度学习文本生成图像模型,其扩散模型利用一系列去噪自编码器,将噪声逐步生成高清图像。Omniverse提供了Stable Diffusion插件集成,借助微服务实现Triton部署加速。

AIGC工具——2维和3维以及多模态

除此以外,NVIDIA还提供了众多AIGC工具,涵盖2维和3维以及多模态。

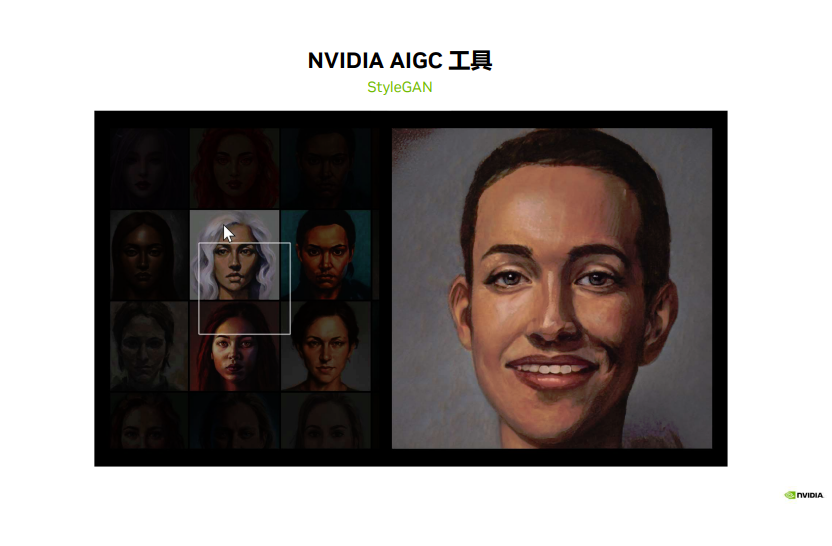

2维图像生成编辑:StyleGAN/EditGAN、Canvas自动绘图软件。其中,StyleGAN生成式对抗网络是一种最先进的高分辨率图像合成方法,从最初的GAN到StyleGAN2变体,其图像合成能力一直在突破人类的想象,而升级版StyleGAN3的对生成细节的把控更是令人惊叹!

虽然生成式对抗网络(generative adversarial networks,GAN)已被广泛用于各种应用,包括图像编辑、图像翻译以及视频生成,现有的控制生成的模型也达到了很高的水平,但总体而言,在合成过程的基础层面仍有极大的改善空间。

在StyleGAN3中,英伟达将网络中的所有信号解释为连续的,并对架构进行轻微调整保证不需要的信息不会泄漏到分层合成过程,最终得到了StyleGAN3,相比于StyleGAN2,它在保证了图像基本质量的同时,明显改善了其内部的表示方式——即使在亚像素尺度上也能实现绝对的平移和旋转。

3维资产生成:GET3D/Magic3D、Replicator: 合成场景数据、GANVerse3D OV插件等。

例如Magic3D将低分辨率生成的粗略模型优化为高分辨率的精细模型,还可以对3D网格进行基于提示的实时编辑。想改变生成模型,只要改改文字提示,就能立即生成新的模型。

另外,Magic3D可以在几代生成图像中均保留相同的主题(一般称为“一致性”),不会出现越画越离谱的情况,并将2D图像(如立体派绘画)的风格应用于3D模型。

不同模态——语音: Riva文本转语音,可根据用户音频数据微调;Audio2Face,输入声音生成表情;Avatar ACE,数字人微服务。

比如Audio2Face只需要一段文字,便能够通过基于AI深度神经网络感知能力的英伟达会话式人工智能系统,来感知语言下的情绪,把一段文字变成丰富的面部表情,再自动基于AI实时渲染系统叠加到虚拟人上。而以前则要进行配音、口形适配,并考虑当前的语态、语境,进行面部表情分离,重新渲染面部表情,整个环节太繁琐,时间、人力、物力成本都过于巨大。

结语

工欲善其事必先利其器,AIGC产业发展离不开产业链上下游的协同发展。

当前,人们对AIGC的探索已经进入了商业化、规模化的阶段。随着越来越多的科技巨头加入这个赛道,创造出令人惊叹的AI生成作品,有理由相信,AIGC的大航海时代已经来临。

本文章选自《AI启示录》杂志,阅读更多杂志内容,请扫描下方二维码