重磅!美国正式公布芯片限制新规!

美国对18个关键盟友与合作伙伴的芯片销售无任何限制。除此之外的大多数国家则将面临总算力限制,每个国家在2025年至2027年期间最多可获得约50000个AI GPU。美国还将免除集体算力较低的芯片销售许可,例如向大学和研究机构的销售。

年终盘点:2024年最炙手可热的10家半导体初创公司

虽然每个季度在企业AI芯片支出中Nvidia要占有高达数百亿美元的份额,但仍有许多公司和投资者认为AI基础设施市场还有空间留给其他赢家,无论是边缘芯片还是数据中心芯片领域。

英特尔:合作伙伴将在2025年推广销售Gaudi 3 AI芯片时发挥“巨大作用”

英特尔美国渠道负责人Michael Green表示,当英特尔的Gaudi 3加速器芯片成为“2025年渠道可用的产品”时,渠道合作伙伴将在推出该芯片的过程中发挥“巨大作用”。

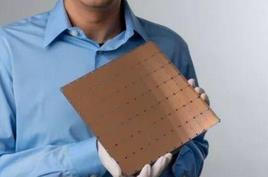

分析丨台积电业绩飙升,这次能站稳万亿美元市值吗?

此前,光刻机领域的领军企业ASML公布的业绩不及预期,引发了市场对于全球芯片制造业[产能过剩]的担忧,并进一步对人工智能需求增长的真实性和可持续性产生了质疑。然而,台积电随后发布的三季度财报及随后的电话会议,显著提振了半导体行业的信心,为美股资本市场带来了积极信号,犹如一剂[强心针]。

AI芯片算力基础及关键参数

AI芯片通常采用GPU和ASIC架构。GPU因其在运算和并行任务处理上的优势成为AI计算中的关键组件,它的算力和显存、带宽决定了GPU的运算能力。GPU的核心可分为CudaCore、Tensor Core等;Tensor Core是增强AI计算的核心,相较于并行计算表现卓越的Cuda Core,它更专注于深度学习领域,通过优化矩阵运算来加速AI深度学习的训练和推理任务

AMD这场AI浓度爆表的发布:各“U”上阵、性能硬核对标,但掌舵10年的苏妈说:“一切刚开始”

在当下的AI竞争格局下,没什么能比一场AI浓度爆表的大会,更能快速彰显自身实力了,AMD的这场「Advancing AI大会」,就是印证。

AWS的AI芯片对成本和供应链“极其重要”

不少解决方案提供商看好AWS投入巨资打造专门针对AWS基础设施优化芯片的计划,该计划将使合作伙伴在AI市场竞争中占据优势,因为电力成本更低,供应链优势更大。

AI芯片对决:英特尔GAUDI与英伟达GPU

因此,英特尔在Computex简报会上公布了产品的定价与基准测试性能,以期展示Gaudi 3与当前“Hopper”H100 GPU的直接比较结果。

云巨头两面下注:亚马逊云科技既要原研AI芯片,又要英伟达GPU

曾几何时,或者说就在短短几年之前,数据中心芯片市场还是个资金门槛极高但却相对简单的市场。CPU战团主要有英特尔、AMD和Arm,GPU阵营则是英伟达、AMD和英特尔等厂商的舞台。尽管AI初创公司数量可观,但普遍并未在数据中心领域建立起真正的话语权。

英特尔筹备出口友好型低功耗Gaudi 3 AI芯片,专供中国市场

英特尔将推出两款专供中国市场的Gaudi 3 AI加速器,根据美国出台的制裁政策对性能做出大幅“阉割”。

产业丨AI芯片战火蔓延,UXL基金狙击英伟达CUDA

Precedence Research近期发布的报告也显示,预计到2032年,涵盖CPU、GPU、ASIC以及FPGA等类型的AI芯片市场规模将从2023年的约219亿美元大幅增长至2274.8亿美元。

走进芯时代:AI算力GPU芯片分析

尽管AI芯片种类繁多,GPU因其适应性和强大的并行计算能力,仍是AI模型训练的主流硬件。英伟达在GPU领域的技术积累和生态建设使其处于领先地位,而国内GPU厂商虽在追赶,但仍存在差距。AI应用向云、边、端全维度发展,模型小型化技术成熟,数据传输需求增加,Chiplet技术降低设计复杂度和成本。

Nvidia AI芯片路线图分析与解读

Nvidia在2023年投资者会议上展示了其GPU发展蓝图,计划在2024年推出H200和B100 GPU,2025年推出X100 GPU。其AI芯片更新周期从两年一次缩短至一年一次,体现产品开发速度加快。Nvidia的“One Architecture”统一架构支持不同环境下的模型训练和部署,适用于数据中心和边缘计算。同时,Nvidia的技术路线图包括HBM3E高速存储器、PCIE 6.0/7.0、NVLink、224G SerDes、1.6T接口等先进技术。

HBM研究框架:突破“内存墙”,封装新突破

HBM技术通过提升I/O口数量和速率,突破内存限制,成为AI芯片的强大辅助。HBM3和HBM3e将成为AI服务器主流配置,预计HBM4将于2026年发布。全球HBM市场预计在2024年超百亿美元。HBM采用TSV+Bumping和TCB键合方式,但散热效率低下,海力士引入MR-MUF工艺改善。预计HBM4将采用混合键合Hybrid Bonding技术,3D封装的核心是混合键合与TSV。

Nvidia发布第四季度财报 AI芯片需求巨大推动数据中心GPU收入大涨409%

今天Nvidia公布了第四季度财务业绩,结果再次超出华尔街预期,使其股价在盘后交易中走高。

有意见 | AI专家全力去模拟世界吧,安全治理的事情就重在参与吧

19 位学界、业界人士忧心忡忡、把酒言欢的搞了一篇论文,把 AI 治理聚焦到了“硬件”和“算力”上。

让普通硬件终端也能跑AI应用,CoCoPIE提供了全新的思路

AI专用硬件的全面普及还需要不短的时间,在此之前,唯一办法就是充分挖掘现有硬件终端本身的计算能力。