AMD公布惊人业绩,第二季度数据中心GPU销售额突破10亿美元

与此前的积极预期相符,AMD再次上调了旗下Instinct MI300系列GPU产品的销售预期。同时随着其“Antares”系列计算引擎在第二季度的收入突破10亿美元,该公司预计2024年全年此类设备的销售总额将一举超过45亿美元。

黄仁勋与扎克伯格做了一场关于Meta生成式AI未来的探讨(附对话实录)

英伟达CEO黄仁勋和Meta CEO马克·扎克伯格,在美国丹佛举行的第50届SIGGRAPH图形大会上进行了一场关于生成式AI的对话,并且他们还互赠了皮衣。

AI First:戴尔帮助各种规模的企业加速 AI 创新

随着AI技术和应用的爆炸式增长,人们正在大步迈入智能世界,大家也期望一个全新的数据中心来支撑 AI 时代的到来,那么未来数据中心是一个什么样子?

聊聊AMD混合CPU-GPU INSTINCT MI300A研发故事:一条漫长而曲折的道路

虽然这笔钱并不算多,但足够让AMD的工程师们有机会考虑整个美国的未来,并为如今强大的CPU与GPU业务埋下种子。

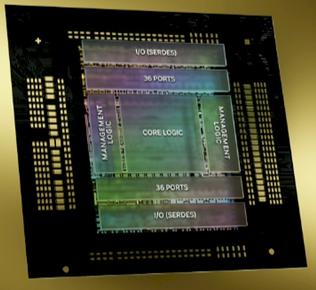

GPU/TPU大集群组网技术分析

用于连接 GPU 服务器中的 8 个 GPU 的 NVLink 交换机也可以用于构建连接 GPU 服务器之间的交换网络。Nvidia 在 2022 年的 Hot Chips 大会上展示了使用 NVswitch 架构连接 32 个节点(或 256 个 GPU)的拓扑结构。由于 NVLink 是专门设计为连接 GPU 的高速点对点链路,所以它具有比传统网络更高的性能和更低的开销。

戴尔与英伟达表示,作为生成式AI的副产品,相关数据将为合作伙伴提供“巨大”的存储机遇

戴尔科技副总裁董事长兼首席运营官Jeff Clarke在2024年戴尔科技世界大会上表示,如果说GPU是AI系统的大脑、网络是其心脏,那么存储就是AI的呼吸与脉搏。

AMD发布“TURIN”EPYC CPU预览,并扩展INSTINCT GPU技术路线图

苏姿丰表示,Zen 5核心是AMD公司有史以来设计出的性能最强、能效最高的核心,而且完全是从零开始打造而成。

英伟达公布截至2027年的GPU与互联技术路线图

作为八大科技巨头共同打造的、用于对抗英伟达的交换技术,让GPU巨头采用UALink当然有点荒谬。但谁知道呢,毕竟技术行业从来不缺少出人意料的故事。

2024年,人工智能、区块链和元宇宙的统一未来!

在最初的兴奋,到2022年对元宇宙的失望,而现在情况又开始好转。这一变化是由于计算机设备制造商取得的进展。就好像我们即将获得“空间计算的iPhone”,它可以真正以我们可以触摸和感受的方式将这些数字世界带入生活。

Nvidia斥资7亿美金收购GPU集群优化初创公司Run:ai

Nvidia今天透露,已经收购了Run:ai,一家开发优化显卡集群性能软件的初创公司。

高性能GPU服务器硬件拓扑与集群组网

一些 GPU 厂商(不是只有 NVIDIA 一家这么做)将将多个 DDR 芯片堆叠之后与 GPU 封装到一起 (后文讲到 H100 时有图),这样每片 GPU 和它自己的显存交互时,就不用再去 PCIe 交换芯片绕一圈,速度最高可以提升一个量级。这种“高带宽内存”(High Bandwidth Memory)缩写就是 HBM。

云巨头两面下注:亚马逊云科技既要原研AI芯片,又要英伟达GPU

曾几何时,或者说就在短短几年之前,数据中心芯片市场还是个资金门槛极高但却相对简单的市场。CPU战团主要有英特尔、AMD和Arm,GPU阵营则是英伟达、AMD和英特尔等厂商的舞台。尽管AI初创公司数量可观,但普遍并未在数据中心领域建立起真正的话语权。

重磅!维谛Vertiv加入英伟达NPN全球生态伙伴网络

维谛Vertiv(NYSE:VRT)作为关键基础设施和连续性解决方案的全球领导者,加入英伟达NVIDIA生态伙伴网络(NPN),并成为解决方案顾问合作伙伴。这一合作将维谛Vertiv丰富的专业知识以及全系列电力与制冷解决方案进行更广泛的应用和推广。

英伟达BLACKWELL系统如何“吃下”万亿级参数AI模型

可以看到,单纯将Hopper替换为Blackwell并不是最好的答案。根据英伟达方面的解释,只有在配合一系列正确举措之后,推理性能提升至30倍、推理功耗降低至1/25的结果才有可能实现。

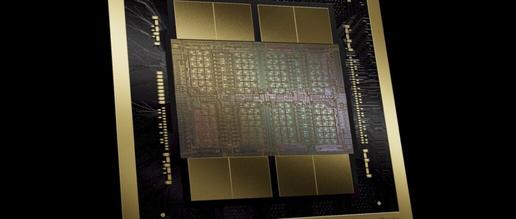

BLACKWELL GPU亮相:AI从此更便宜、更简单,英伟达竞争优势愈发凸显

日前在圣何塞举行的2024年GPU技术大会上公布的英伟达“Blackwell”GPU,是这家计算引擎制造商推出的第七代、也是最令人印象深刻的数据中心级GPU。GPU计算浪潮始于2000年代中期,并随着2012年5月“Kepler”K10与K20加速器的推出而变得愈发清晰具体。

走进芯时代:AI算力GPU芯片分析

尽管AI芯片种类繁多,GPU因其适应性和强大的并行计算能力,仍是AI模型训练的主流硬件。英伟达在GPU领域的技术积累和生态建设使其处于领先地位,而国内GPU厂商虽在追赶,但仍存在差距。AI应用向云、边、端全维度发展,模型小型化技术成熟,数据传输需求增加,Chiplet技术降低设计复杂度和成本。

META PLATFORMS大规模GPU设施全解析

如果大家每天需要处理数百万亿次AI模型执行,并在生成式AI步入主流的背景下时刻准备将这样的负载规模再提升一、两个数量级,那GPU就是各位不可或缺的战略资源。Meta Platforms明显就是这样,他们正拿出大笔财务预算,想要用“钞能力”从英伟达手中夺取显卡产能。