十年一剑,TPU引领AI芯片时代

TPU 的设定,只能在 TensorFlow 中执行推理,但它的性能非常好。我们认为,TPU 与 TensorFlow 的良好适配,能够发挥出 1+1>2 的效果。深度学习计算中的芯片部署都不是零和博弈。现实世界的深度学习网络需要系统的 GPU 与其他 GPU 或诸如 Google TPU 之类的 ASIC 通信。GPU 是理想的工作环境,具有深度学习所需的灵活性

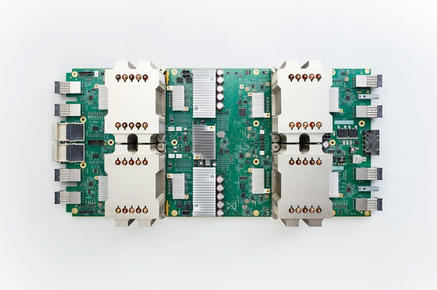

Google Cloud发布下一代TPU和GPU集群 增强AI Hypercomputer堆栈

Google宣布推出了第六代张量处理单元Trillium TPU,以及即将推出由Nvidia H200 GPU驱动的新型A3 Ultra虚拟机,此外还有基于Axion Arm架构的C4A VM,从今天正式面世。

AI芯片算力基础及关键参数

AI芯片通常采用GPU和ASIC架构。GPU因其在运算和并行任务处理上的优势成为AI计算中的关键组件,它的算力和显存、带宽决定了GPU的运算能力。GPU的核心可分为CudaCore、Tensor Core等;Tensor Core是增强AI计算的核心,相较于并行计算表现卓越的Cuda Core,它更专注于深度学习领域,通过优化矩阵运算来加速AI深度学习的训练和推理任务

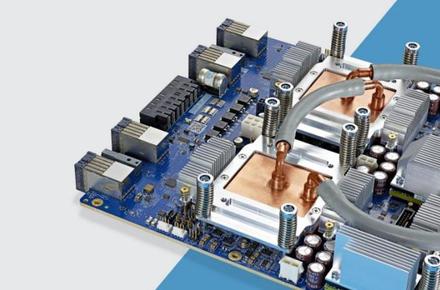

谷歌发布Cloud TPU Pod以实现按需的AI超级计算机

谷歌今天宣布对其云平台进行扩展,发布了一个新的基础设施选项Cloud TPU Pod,旨在满足那些需要大量计算能力的大型人工智能项目。

谷歌宣布公有云平台将支持面向人工智能的TPU芯片

谷歌今天宣布向其公有云平台上增加ensor Processing Units,这是一款专门为人工智能工作负载提供动力的内部设计的芯片系列。