Jetson百万开发者故事 | 校企合作推动实现多项工业场景下AI边缘计算应用

基于Jetson Nano模块开发的Thrust Nano 5G施工安全监控系统可以部署各种主流的深度目标检测模型,例如:YOLO v3-v5系列模型以及SSD_Mobilenet系列模型。

Jetson百万开发者故事 | NVIDIA Jetson助力水产养殖企业打造自动化流水线

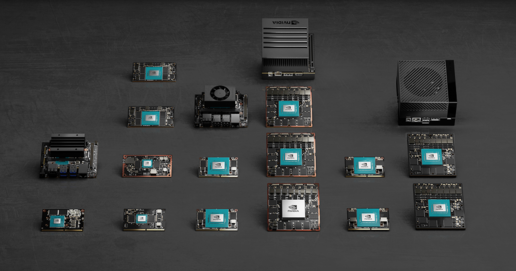

作为资深开发者,已经使用了好几代NVIDIA Jetson产品的林锐说:“Jetson系列有多个不同型号的设备,适用于不同的应用场景和需求。因此,在选择Jetson设备时,需要根据自己的需求选择合适的设备。”

Jetson百万开发者故事 | 基于Jetson Nano的便携式岩石分类检测系统:地质学家的新利器

来自湖北工程学院数学与统计学院的学生团队,在导师张天凡的带领下,决定设计一款适合野外作业的便携式岩石分类检测系统。

Jetson百万开发者故事 | 让AI成为铁路客运站自动扶梯安全管控的关键

软件和AI模型的更新通常需要数周时间完成,但是研发团队使用NVIDIA平台显著加快了开发时间,确保了开发和部署流程的快速性,更重要的是,能够在现场环境中测试软件,确保准确性和FPS符合解决方案的要求。

Jetson百万开发者故事 | Jetson开发者突破百万,从TK1到Orin我都经历了啥

袁博融老师是在硕士毕业前才接触NVIDIA Jetson的。那时刚完成论文答辩,有了些空闲时间,便趁着教育优惠还没到期入手了一套NVIDIA Jetson TX1。

Jetson百万开发者故事 | NVIDIA Jetson如何成为可移动智能脑机交互平台

复旦大学类脑人工智能科学与技术研究院副院长王守岩教授团队开创性地应用 NVIDIA Jetson 边缘计算平台,打造了可移动智能脑机交互平台,并应用该平台进行了一系列脑疾病相关的科学及转化研究。

全新NVIDIA Jetson Orin NX 16GB大幅提升边缘AI性能

借去年NVIDIA Jetson边缘AI设备扩展之势,NVIDIA Jetson Orin NX 16GB模块现已在全球上市。

Triton推理服务器13-模型与调度器(3)

前面两篇文章,已经将Triton的“无状态模型”、“有状态模型”与标准调度器的动态批量处理器与序列批量处理器的使用方式,做了较完整的说明。

Triton推理服务器12-模型与调度器(2)

在“Triton推理服务器11-模型调度器(1)”文章中,已经说明了有状态(stateful)模型的“控制输入”与“隐式状态管理”的使用方式,本文内容接着就继续说明“调度策略”的使用。

Triton推理服务器03-开发资源说明

大部分要学习Triton推理服务器的入门者,都会被搜索引擎或网上文章引导至官方的https://developer.nvidia.com/nvidia-triton-inference-server处(如下截图),然后从“Get Started”直接安装服务器与用户端软件、创建基础的模型仓、执行一些最基本的范例。

为AI喝彩:初创企业蒙大维推出首款商用智能电动“司机可选”拖拉机

Monarch成立于2018年。此番推出MK-V Founder为该公司两年的开发冲刺画上了句号。这款拖拉机搭载了节能的NVIDIA Jetson边缘AI和机器人平台、摄像头以及GPS,旨在提高粮食生产产量和减少全球碳排放。

Orin开发套件11-从头创建Jetson的容器(2)

本系列文章的目的就是为大家解开这些变量的意义,让读者能清楚识别出这些变量之间的关系,提升对Dockerfile配置文件的了解,最终协助读者进一步简化出自己所需要的特定脚本与配置内容,以自己创建Docker镜像的能力。

Orin开发套件10-从头创建Jetson的容器(1)

使用Docker容器的最大好处就是“独立性强”,在前面文章中我们教大家如何使用NVIDIA在NGC提供创建好的l4t-ml系列镜像为基础,去创建各种机器学习/深度学习的开发或部署用途的独立容器,包括各种基于TensorRT的推理应用、基于Pytorch的各种YOLO相关应用等等。

Orin开发套件11-创建各种YOLO-l4t容器

YOLO(You Only Look Once)算法是近年非常知名的深度神经网络结构,由于创始人在v3版本之后便宣布退出领域,于是从v4版之后便出现较多的分支,到2022年8月已经有v5、v6与v7与三大分支争奇斗艳,其中v7版是v4版的增强,由同一个团队进行开发与维护。

Orin开发套件09-为容器接入USB摄像头

前面教大家使用DeepStream的Docker镜像去创建自己的Python工作环境,其好处是即使Jetson设备需要使用JetPack重新安装系统,我们只要重新启动这个Docker容器就可以,无需重复环境配置的工作。

硬件创新与软件赋能 NVIDIA Jetson生态协同让边缘AI加速落地

NVIDIA亚太区开发者发展总监李铭告诉记者,NVIDIA边缘计算的最大特点是基于统一的架构,也就是Jetson与其他NVIDIA平台上所用的相同AI软件和云原生工作流相兼容,并能为客户提供构建软件定义的自主机器所需的性能和能效。

NVIDIA Metropolis成员使用NVIDIA Jetson AGX Orin提供支持的AI计算机视觉平台实现汽车自主移动。

LV5 CTRL TWR是由用于创建GPU加速应用的NVIDIA CUDA库以及用于边缘高性能AI的NVIDIA Jetson AGX Orin模块构建的。NVIDIA GPU在云端用于全局车队路径规划。

Nvidia发布首个用于生产部署的Jetson AGX Orin模块

Nvidia即将推出Jetson AGX Orin平台的一款生产用模块,旨在嵌入设备内部,并为机器人和边缘计算等各种应用提供AI加速。